AI Objekterkennung

Wir testen gerade das Update bzgl. der erweiterten Objekterkennung. Mit dem nächsten Update wird die Kamera insgesamt 19 Klassen erkennen und diese per HTTP und MQTT bei einen Alarmserver (Smarthome) melden können.

Die neuen Objektklassen sind:

personfacecarnumberplatemotorbiketrainvanbustruckbikeboatplanehelicopterdogcatbirddeerhorsecow

HTTP Alarmserver

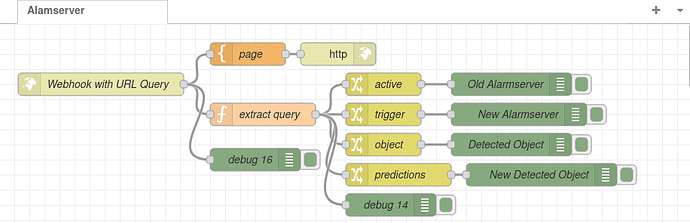

Beim HTTP Alarmserver schaut das ganze jetzt so aus:

Hier sind active und object die Queries die bereits in der alten Firmware vorhanden waren. Diese zeigen den ersten Alarmauslöser und das erste gefundene Objekt (hier werden weiterhin nur die 3 Klassen Person, Auto, Tier ausgeben).

Neu hinzugekommen sind triggers und predictions. Beim ersten werden jetzt alle Alarmauslöser ausgegeben. Wie diese Ausgabe auszuwerten ist hatten wir bereits hier beschrieben:

Und eine Beispiel Implementierung in Node-RED findet man hier:

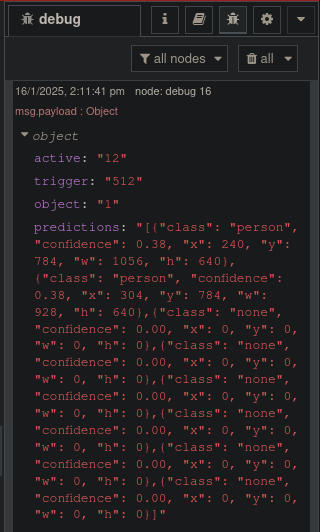

Der Query predictions beinhaltet jetzt bis zu 8 Objekte, die während der Alarmauslösung im Bild erkannt wurden. Diese Information wird als JSON Array ausgegeben und hat pro Erkennung den Klassennamen, die Sicherheit der Erkennung und die Koordinaten der Region in der das Objekt erkannt wurde:

[

{

"class": "person",

"confidence": 0.38,

"x": 240,

"y": 784,

"w": 1056,

"h": 640

},

usw..

]

MQTT Alarmserver

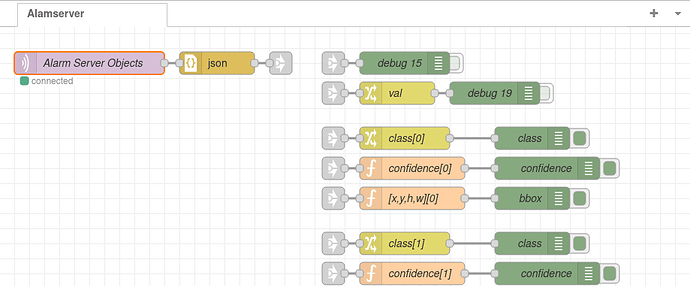

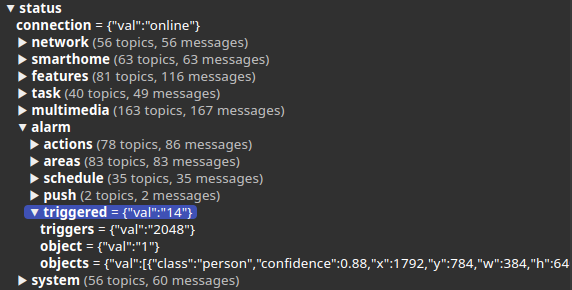

Wie in den Wiki Links oben beschrieben waren die Auslöser bereits zuvor im MQTT integriert. Die oben beschriebenen „Vorhersagen“ der Objekterkennung werden unter dem folgenden MQTT Topic in der oben beschriebenen JSON Array Form veröffentlicht:

alarm/triggered/objects

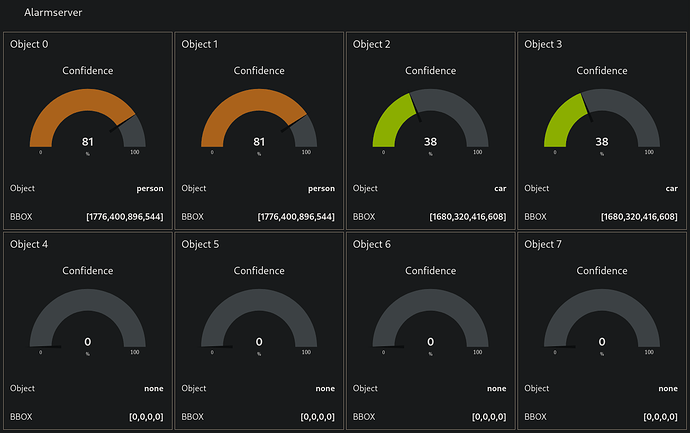

Hier ein Beipiel einer Node-RED Implementierung:

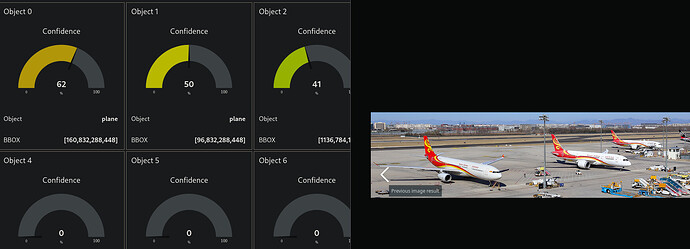

Wenn man jetzt die Kamera vor den Monitor stellt und eine Bildersuche startet bekommt man die Vorhersagen entsprechend direkt angezeigt: